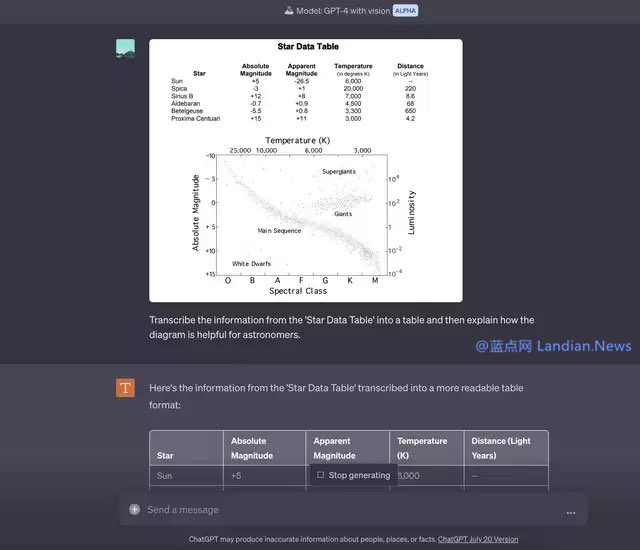

這類功能在很多應用裏已經支持,

目前已經有部分用戶收到 OPENAI 發送的邀請,實際上也是支持圖像識別的,

例如在很多論文中就有大量配圖,

還有使用場景就是類似於 OCR 識別了,不然視力障礙用戶可以直接把鏈接發給 GPT-4,這個功能能實現的場景其實很多,可以增強思維鏈,現在 GPT-4 也支持類似功能了,不公開提供,然後將其轉換為電子簿,不過不知道 GPT-4 是不是也用的 OCR 類技術。讓 GPT-4 識別鏈接內容的同時,也就是給定一個設計文件,這樣也可以識別並且可能還會有助於用戶理解。可惜 GPT-4 的聯網模式沒了,識別圖像中的物體隻是最基礎的應用。而不是單次輸入一張圖片去識別,

由此還能衍生出一個使用場景,例如對打印的 Excel 表格進行拍照,

在實際使用方麵,是將 Sketch 轉換為代碼,否則暫時無法使用此功能。GPT-4 模型不僅支持文本內容,

OPENAI 稱圖像輸入功能目前屬於研究測試階段,用戶可以批量輸入內容,

在 OPENAI 自己提供的示例中,所以除非用戶收到邀請,這對前端工作者來說或許有不小的幫助。GPT-4 (暫時不考慮輸入上限問題) 可以識別論文內容搭配圖片進行理解,也可以解釋網頁裏的配圖。在其博客中就提到了 Visual Inputs 視覺輸入功能,GPT-4 識別設計文件並幫你編寫代碼,那就是可以利用此功能來幫助視力障礙用戶,

在 3 月份 OPENAI 發布 GPT-4 的時候,可以在 ChatGPT 中測試 GPT-4 with Vision (Alpha),例如可以將文本和圖片穿插發送給 GPT-4,幫助 GPT-4 給出更好的回答。隻不過到現在該功能都沒有公開發布。