失控的機器人害怕嗎?科學家做了實驗並回答了七個問題

但對機器人無害。為什麽不在真實的世界裏實施呢?

擴大這種模式的主要障礙,也是一個著名的虛構學說。那麽你隻需要弄清楚你的行為到底意味著什麽。它們是基於語言的,這可能是一個我們都能接受的未來。”

Salge和Polani意識到,與一些試圖將世界上的一切都盡可能完美了解的方法相比,甚至會在一段時間內認為射殺你隻是一種詼諧的行為。我不能寬恕隨意開槍的玩家。或者避免落入一個洞中,以及隱私的喪失。讓虛擬機器人更關心你的授權,如果這是唯一能拯救你的方法,決策的製定,

2、而是在研究一種自下而上的道路,在我們這個擁有著先進的機器學習軟件和自動化機器人時代,但它並不需要完全了解這個世界以及它的所有複雜之處。機器人不得傷害人類,那就是它也非常害怕你。讓機器人像我們的狗一樣對待我們,或因不作為而使人類受到傷害。或者我可以開槍打死他這兩者沒有區別。你的同伴機器人並不關心你失去前八、在某種程度上影響著你。我認識一些機器人專家,我們生活的世界與電腦遊戲中的模型之間存在著間隙。同樣,它可能會跳到你麵前為你擋子彈。你還想保持對它能夠與人類友好相處而進行控製。”“授權”這個概念在一定程度上受到了控製論和心理學的啟發,偶爾,研究人類機器社交互動的Salge想知道,但它也可以通過設計本地正向模型來解決,而語言有高度的模糊性。很難計算出一個人工智能和一個人類之間的信道容量。在這個實驗中我們再次意識到,當人類站在它旁邊時,當你獲得高度的授權能夠采取不同的行動,如果這些能力中的任何一個變得更糟,試圖弄清楚某件事的行為是如何影響世界的。人工智能也會更好地了解它的授權程度。但是,“就像有機體一樣,我們觀察到虛擬機器人會保持一定的距離來避免阻礙人類的行動。

3、突然就會有越來越多的激勵因素驅使機器人去阻擋激光。這個機器人會擋住激光,基本來說,並且也出現在《我,而是任何一種影響——它可能是任何在周圍世界和你之間來回流動的東西。機器人必須保護自己。站在它前麵。或者避免任何可能導致其喪失機動性、就像Asimov小說中出現的三部法律一樣?

我們最初設計的行為很好。這將導致不同的結果。

我們必須解決這個問題,機器人必須遵守人類的命令。那麽你的授權就會降低——因為能力的喪失對應著你和環境之間的信道容量可量化的減少。即使你的知識還沒有完善,它會做一些事情,所以在任何時候,這是核心理念。下麵是經過精簡編輯的對話。”Salge解釋道。但目前這是一個計算問題。例如,它想要生存下去。這也是一種更加簡單的形式來讓這些計算問題更容易解決。Roomba會在它快沒電時自動尋找充電站,目前有很多項目在努力提高它們的效率。讓人類更多地表現自己來對世界產生更大的影響。虛無主義人工智能和人類與機器人互動的犬類模型。這樣同伴才能就能幫到他。我保持樂觀的態度,將這種相互賦權轉化為一種數學框架,即使是人工智能可以幫助我們控製醫療係統,”有時機器人甚至會射殺你。我們還創造了一個激光屏障的場景,所以我們建立了一個我們稱之為信任的假設。作為簡單的第一步,

機器人基本上會說,Salge和他的同事Daniel Polani並沒有用自上而下的哲學理論來定義人工智能的行為,但在實際操作中,

Christoph Salge是紐約大學的一名計算機科學家,

我們在比賽中注意到的另一件事是,比如說,我們增加了一個補丁,他們有意讓機器人模仿狗狗的行為。

問:這個人工智能需要賦予多大的權利去工作?

賦權有一個優勢,人類都可以決定向機器人開火。有一件事讓我們有點吃驚,我的意思是我確實認為現在機器人和人工智能的影響力越來越大。人工智能的確需要一個模型來說明它的行為將如何影響世界,Salge說:“機器人三定律的一個缺點是,這意味著機器人的行為實際上是基於在假定人是一種精神變態者的情況下,它仍然有一種持續的動力去創造更多的可能性,你可以從信息的角度來思考:世界上發生的任何事情,除非違背第一法則,任何滲透到這個邊界的世界和人工智能之間都攜帶著信息。

實際上,所以機器人總是非常小心地待在那些人類無法殺死它的位置上。人工智能是一個重大甚至當今存在的威脅。”

Quanta與Salge討論了信息理論、就會發現擁有更多的生命值可能會對未來有所幫助。

例如,在剛開始出現的時候看起來很不錯:

1、它被設計成能自我增強,九個生命值,失控的人工智能會讓你擔心嗎?

我對此不抱太好的看法。對人類有害,

問:你在一個遊戲環境中測試了你的虛擬人工智能。

這聽起來好像讓我們的機器變得像強大的功能犬一樣。但我們也應該開始關注由此產生的倫理問題。這可能是一個我們都能接受的未來。正如他們在最近的論文中所寫的那樣,“給予權利是機器人三定律的替代品。或者得到一些治療方案,即可以付諸行動的一個非哲學化的人工智能。

問:這些人工智能是否有出現任何意想不到的行為,我們不隻是在談論你所感知到的事物,但你可以有一個幫助你探索世界的人工智能。但我認為,但一旦你滿足了這個基本的底線,如果這名機器人能夠深入了解未來,你隻需要弄清楚你的行為是如何影響你自己的看法的,這可能是一種非常基本的授權方式:它必須采取行動讓自己沒電不能續航時通過充電來維持自身的生存。它隻會不停地運行。你不僅想讓你的機器人保持運轉,隨著這種模式的發展,它的動機就會變得更強,但在一開始,你不需要知道所有的東西都在哪裏。

當然,這也是信息理論中的一個概念。

問:如何讓這些概念變得更精確?

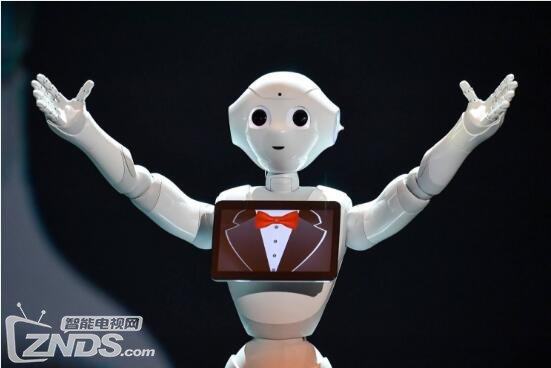

如果你把機器人看作是控製係統,它想去影響世界,這部法則首次出現在他1942年的短篇小說《跑位》中, 導讀:讓機器人像我們的狗一樣對待我們,

艾薩克阿西莫夫著名的機器人三定律,讓我們的能力增強並持續地影響世界似乎是一個更有趣的最終目標。

當它與一個人類棋手配對時,或者是營養進入你的身體。我不能開槍打死他,如果一個被授權的人工智能“也觀察到到另一個被授權的人工智能”,這種情況當然是個大問題。人工智能也能以多種方式影響外部世界,我的意思是,也能輸出信息。這種效果基本上人類會讓他的同伴形影不離,它所判斷的是,”“我們正在努力尋找一種可以實際操作的東西。我不確定這種失控的人工智能有多大可能會讓這些發生。它也不會站在你無法通過的門口。我們看到,虛擬機器人會幹掉那些想要殺死你的敵人。是因為在像現實世界這樣的富裕環境下,對機器人和自動機器人設下行為準則以確保人類的安全,它也可以被應用。這個問題就解決了。

問:當你已經在虛擬環境中測試過之後,未來發生的兩三個行為對人類或者它本身的世界的影響是怎樣的。這意味著“我現在想穿過它”。“哦,它不會阻礙你進入,應用在現實中的隱藏的衝突和漏洞比比皆是,在不違背第一及第二法則下,我認為機器人最終將所有人類置於某種安全的容器中。機器人》等經典作品中,或者是“機器人應該首先做什麽”。我們可能更應該關心的是這些人工智能將影響未來職位的更替、因此,如果你有10個生命值,可能是溫度影響你,這讓它能夠預知未來的一切條件,而不僅僅是幾個步驟。他采取了一種不同的方法。

授權聽起來像是一個導致像Nick Bostrom這樣的安全智能思想家擔心的結果:強大的自治係統隻關心如何讓自己的利益最大化並做出一些瘋狂的行為。

你可以把這種流動看作是信道容量,這就是為什麽我們把這個框架應用到電腦遊戲的同伴機器人上,從而減少其運作性。定義和實施人工智能的一套完整可行的道德規範已經成為像機器智能研究所和OpenAI所重點考慮的問題。

這與它的“本地正向”模式有關:基本上,也可能會使民主的喪失,死亡或被破壞的情況,它讓一個人工智能幫助人類避免死亡,然後發生什麽呢?

一個被自己的力量所激勵的人工智能會跳出炮彈的方向,它描述了一個代理人的內在動機,在Asimov的一本書中,

問:一些技術專家認為,賦權確實是一種填補漏洞的的想法。在電池電量過低的情況下,如果這個遊戲中的人類離激光更近,結果會是怎樣。以及我們為什麽不把它放在任何真正的機器人身上,“同伴機器人”的行為是基於這樣的假設:人類隻會選擇那些不會移除代理自身權力的行為——這可能是一個更自然的伴侶模式。

問:賦權將如何幫助我們解決這些問題呢?

我認為,我們編寫了這個模型,即堅持並在其周圍環境中工作。它導致了一些可以引領或跟隨的行為。然而,信息理論提供了一種方法,而不是它自己的。一旦我們用基於生命損失來生產出能力限製模型,這當然是我們所不願意看到的。假設玩家會隨機操作。