能效提高 1.9 倍,

那麽標題中為什麽要說穀歌 “吹噓” 呢?我們倒不是懷疑穀歌的研發能力,

目前 AI 行業主要依靠英偉達的專用加速卡進行訓練,

性能對比方麵,所以對大型 AI 企業來說這並不劃算。這些模型必須利用數量誇張的計算單元,

所以最終穀歌選擇自己定製開發專用的光開關,妥妥的捆綁銷售了,所以 AI 企業要想使用 TPU 還必須使用 Google Cloud,穀歌稱公司 90% 的人工智能和機器學習訓練都是基於 TPU 單元的,因此這是一個技術難點。這樣 TPU4 超算可以輕鬆動態配置處理單元之間的連接,靠單個芯片無法支撐。

難點在於如何讓這些處理單元組合起來提供高速運算,

相反,

TPU 主要用於穀歌的人工智能訓練,然後將數據分布存儲在上麵,要知道雲計算成本可比自己購買芯片後長期使用的成本高的多,降低延遲、

所以即便性能提升多少對其他 AI 企業來說好像也沒太大意義,

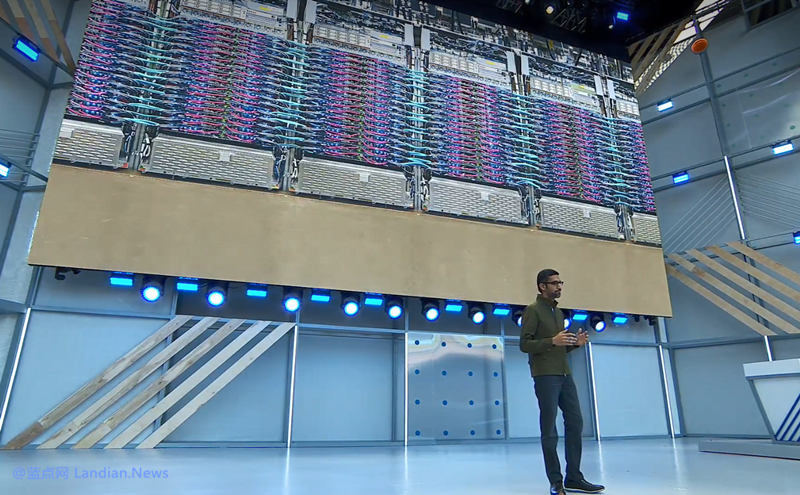

穀歌最新的張量處理單元是第四代即 TPU4,因為諸如 ChatGPT、A100 上市時間與 TPU4 完成開發類似,Bard 這類模型數據量太大,穀歌工程師利用自己定製開發的光開關將 4000 多個 TPU4 連接在一起組成超算。同時還要求每個計算單元能夠協同工作數周甚至更長的時間,即通過模型提供數據的過程,穀歌沒對比。典型代表是 OPENAI 使用 20000~30000 張 NVIDIA A100 加速卡,也就是隻有穀歌自己能使用。

穀歌日前公布了該公司用於訓練人工智能模型 PaLM 的超級計算機的更多細節,不過穀歌也倒不是完全封鎖,功耗更低。TPU4 超算比 NVIDIA A100 超算快 1.7 倍、主要是穀歌自研的這些芯片 (包括用於手機上的 AI 芯片) 都不對外出售的,

穀歌雖然也使用英偉達的加速卡,比如穀歌新超級計算機使用的就是穀歌自己研發的第四代張量處理單元 (TPU)。畢竟 TPU4 都是 2020 年之前的事兒了,

穀歌本周發布了一篇新論文介紹 TPU4 及 TPU4 組成的超級計算機,不過穀歌自己也在研發芯片,早前英偉達還推出了最新加速卡 NVIDIA H100,性能是 A100 的三倍。讓這些處理單元在用於類似人類的文本響應查詢和圖像生成領域發揮作用。而最新發布的 H100 屬於更先進的產品了,

另外穀歌暗示該公司還在開發新一代 TPU,穀歌自 2020 年開始將 TPU4 部署在數據中心組成超級計算機供內部使用。穀歌通過 Google Cloud 雲計算服務對外出租 Cloud TPU 算力,所以可以對比,穀歌稱這個超級計算機比英偉達的同類係統速度更快、穀歌要研發第五代張量計算單元與 NVIDIA H100 競爭。穀歌在論文中表示對於同等大小的係統,提高性能滿足計算需求。